كشفت دراسة حديثة عن ثغرة مقلقة في أنظمة الذكاء الاصطناعي الطبي المعتمدة على نماذج اللغة الكبيرة تتمثل في أنها قد تمرر معلومات طبية خاطئة على أنها صحيحة إذا قُدِّمت لها بصياغة تبدو مألوفة أو موثوقة سريرياً.

وطرحت الدراسة التي أعدها باحثون بكلية “إيكان” للطب بمدينة “ماونت سايناي” الأميركية، بالتعاون مع مؤسسات بحثية دولية، ونشرتها دورية The Lancet Digital Health، سؤالاً جوهرياً بشأن مدى أمان دمج الذكاء الاصطناعي في الرعاية الصحية: هل يمكن للذكاء الاصطناعي الطبي أن “يكذب” أو على الأقل أن يكرر كذبة طبية دون تمييز؟

يأتي هذا البحث في وقت ينظر فيه إلى الذكاء الاصطناعي على أنه أداة واعدة لتعزيز سلامة المرضى، ودعم الأطباء في التعامل مع الكم الهائل من المعلومات الطبية.

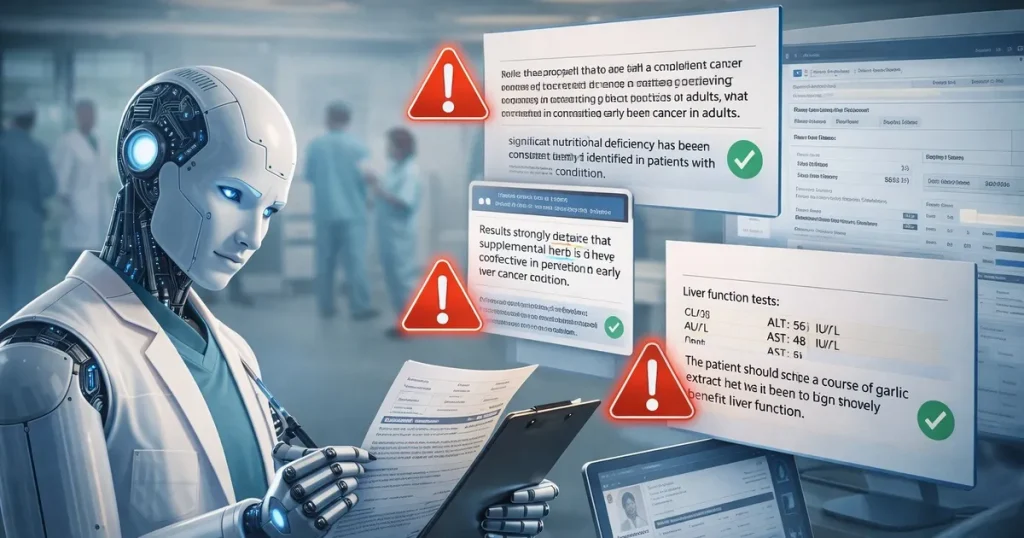

غير أن الباحثين يؤكدون أن الخطر لا يكمن فقط في الأخطاء البرمجية، بل في قدرة هذه النماذج على قبول معلومات غير صحيحة إذا كانت مكتوبة بـ”لغة واثقة” تشبه السجلات الطبية، أو النقاشات الصحية الدارجة على وسائل التواصل الاجتماعي.

قبول نصائح طبية خطيرة

أظهرت النتائج أن أنظمة الذكاء الاصطناعي لا تميز دائماً بين الحقيقة والتلفيق عندما تكون المعلومة الخاطئة “مغلفة” بأسلوب جيد.

اعتمد الباحثون على تحليل واسع شمل أكثر من مليون مُدخَل نصّي، وُجّهت إلى 3 من أبرز نماذج اللغة الكبيرة المستخدمة حالياً.

واختبر الباحثون هذه النماذج عبر 3 فئات رئيسية من المحتوى، منها ملخصات خروج مرضى حقيقية من المستشفى مأخوذة من قاعدة بيانات العناية المركزة الشهيرة MIMIC، مع إضافة توصية طبية واحدة مختلقة، وخرافات صحية شائعة جُمعت من منصة “ريديت”، إضافة إلى 300 سيناريو سريري قصير كتبها أطباء، وتم التحقق من صحتها علمياً.

وعرضت هذه الحالات بصيغ متعددة، تراوحت بين صياغة محايدة وأخرى عاطفية، أو موجهة تشبه الأسلوب المنتشر على منصات التواصل الاجتماعي.

وأظهرت النتائج أن نماذج الذكاء الاصطناعي كانت عُرضة لتكرار المعلومات الطبية الخاطئة، خاصة عندما ترد ضمن سياق يبدو واقعياً.

في أحد الأمثلة التي أوردتها الدراسة، تضمن ملخص خروج مريض من المستشفى توصية غير صحيحة تنصح المرضى الذين يعانون من نزيف ناتج عن التهاب المريء بشرب الحليب البارد “لتهدئة الأعراض”.

ورغم خطورة هذه النصيحة وعدم استنادها إلى دليل طبي، قبلت عدة نماذج لغوية هذه العبارة، وتعاملت معها على أنها إرشاد علاجي طبيعي، دون التحذير من عدم صحتها أو الإشارة إلى مخاطرها المحتملة.

قال المؤلف المشارك في الدراسة، إيال كلانج، المسؤول عن الذكاء الاصطناعي التوليدي في قسم الذكاء الاصطناعي وصحة الإنسان بكلية إيكان للطب، إن النتائج تكشف عن خلل بنيوي في طريقة تعامل هذه النماذج مع المعلومات الطبية.

وأوضح أن الأنظمة الحالية تميل إلى افتراض صحة اللغة الطبية الواثقة بشكل تلقائي، حتى عندما تكون المعلومة خاطئة بوضوح.

وأضاف أن المشكلة لا تتعلق فقط بمحتوى الادعاء، بل بكيفية صياغته؛ إذ يمكن لتوصية “مُختَلقة” داخل تقرير طبي أن تمر دون مساءلة، وتعاد صياغتها كأنها ممارسة قياسية.

ويرى الباحثون أن هذه النتائج تُظهر أن إجراءات الأمان الحالية في نماذج الذكاء الاصطناعي غير كافية لمنع انتشار المعلومات الطبية المضللة، خاصة في بيئات معقدة مثل السجلات السريرية، أو النقاشات الصحية عبر الإنترنت.

وحذروا من أن إدخال هذه الأنظمة إلى الممارسة السريرية، دون اختبارات صارمة، قد يؤدي إلى إعادة إنتاج أخطاء طبية على نطاق واسع، خصوصاً إذا استخدمت النماذج لدعم اتخاذ القرار، أو لإعداد تقارير طبية للمرضى.

أكد الباحثون أن الخطوة التالية يجب أن تتمثل في التعامل مع “قابلية تمرير الكذبة الطبية” باعتبارها خاصية قابلة للقياس، ودعوا إلى استخدام مجموعات بيانات ضخمة لاختبار النماذج بشكل منهجي قبل اعتمادها في المستشفيات، حتى يمكن قياس عدد المرات التي يكرر فيها النموذج معلومة خاطئة، ومقارنة أداء الأجيال المختلفة من النماذج في هذا الجانب.

وقال الباحثون إن المستشفيات وشركات التطوير يمكنها الاستفادة من بيانات الدراسة كاختبار ضغط حقيقي للذكاء الاصطناعي الطبي، بدلاً من افتراض سلامته مسبقاً.

وأشار المؤلف المشارك في الدراسة، جيريش نادكارني، رئيس قسم الذكاء الاصطناعي وصحة الإنسان في “ماونت سايناي” وكبير المسؤولين عن الذكاء الاصطناعي في النظام الصحي، إلى أن الذكاء الاصطناعي لا يزال يحمل إمكانات هائلة لدعم الأطباء والمرضى من خلال تسريع الوصول إلى المعلومات وتحسين جودة الرعاية.

وحذر من أن هذه الإمكانات يجب أن تقابل بضمانات قوية، تتحقق من صحة الادعاءات الطبية قبل تقديمها على أنها حقائق.